模型引擎挂件

模型引擎挂件是我们提供的一种在线快速体验模型推理的能力,当模型配置了合适框架和任务类型时,模型详情页右侧将显示可在线体验的挂件。

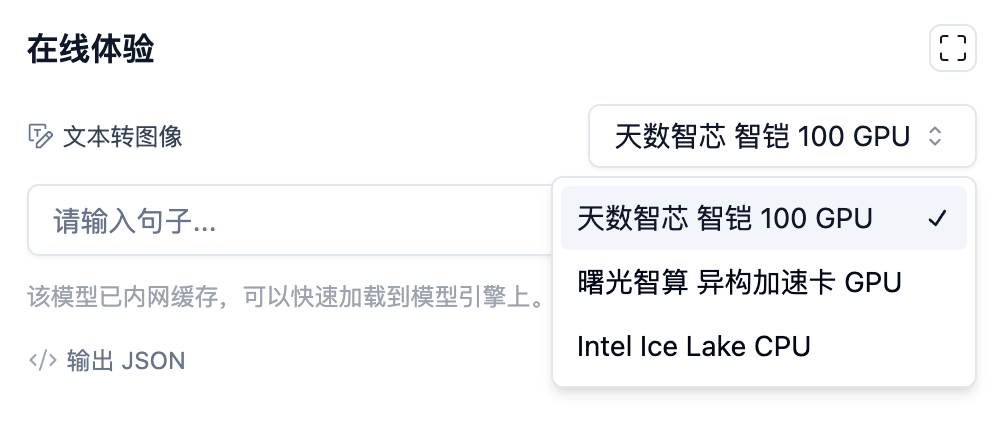

模型引擎背后使用了共享的免费算力,我们也支持选择不同种类算力资源,其中包含国产 GPU 和 Intel CPU。

不同任务类型的模型将使用不同的挂件,请按照挂件提示尝试运行挂件。

支持框架

我们暂时支持的框架 有:

- Transformers

- Diffusers

其他框架仍在适配中,敬请期待。

支持任务类型

我们支持的任务类型有:

- 自动语音识别

- 特征抽取

- 填空

- 图像分类

- 问答

- 句子相似度

- 端到端文本生成

- 文本分类

- 文本生成

- 序列标注

- 文本转图像

- 翻译

未支持的任务类型

暂未支持的任务类型有:

- 音频转音频

- 音频分类

- 对话生成

- 图像转图像

- 图像描述

- 图像分割

- 物体检测

- 文本摘要

- 表格问答

- 文本转语音

- 表格分类

- 表格回归

- 视觉问答

- 强化学习

- 零样本分类

- 文档问答

- 零样本�图像分类

运行流程

当选择不同算力资源时,模型引擎会自动切换到对应的算力资源上进行推理,而这一过程将经历如下过程:

- 创建模型推理服务实例,为服务实例分配算力资源。由于算力资源有限,可能出现 GPU 不足的情况,如遇到此类情况,请稍后再试。

- 下载模型到算力对应的集群(不同算力资源一般位于不同地区的数据中心)将耗费一定时间,请耐心等待。我们会为某些模型提前在数据中心内缓存,以加快下载速度。

- 加载模型到 GPU 或内存中,并提供 API 服务,供挂件或用户调用。

用于原型测试的推断 API

除了使用挂件进行在线体验外,我们还提供了推断 API,供用户在产品原型阶段调用。