国产算力

在应用中使用国产算力非常简单,只需要注意几点即可。

天数智芯 天垓 100

-

天垓 100 应用环境已内置适配好驱动、软件,您无需关心兼容和安装问题。

下列软件版本不可更改:

torch==2.1.1+corex.20240627082324

torch_cluster==1.6.0+corex.3.2.0

torch_quiver==0.1.0+corex.3.2.0

torch_scatter==2.1.0+corex.3.2.0

torch_sparse==0.6.16+corex.3.2.0

torchaudio==2.1.0+corex.3.2.0

torchvision==0.16.0+corex.3.2.0

vllm==0.3.3+corex.20240702092246

tensorflow==2.12.0+corex.3.2.0

diffusers==0.29.0+corex.3.2.0

cupy==11.4.0+corex.3.2.0

dali==1.21.0+corex.3.2.0

dropout_layer_norm==0.1+corex.3.2.0

flash_attn==2.0.1+corex.3.2.0

fused_dense_lib==0.1+corex.3.2.0

fused_softmax_lib==0.1+corex.3.2.0

horovod==0.27.0+corex.3.2.0

igie==0.9.dev0+corex.3.2.0

ixformer==0.4.0+corex.3.2.0

megatron_deepspeed==0.2.1rc0+corex.3.2.0

mxnet==1.9.0+corex.3.2.0

onnxruntime-gpu==1.13.1+corex.3.2.0

paddlepaddle==2.4.1+corex.3.2.0

rotary_emb==0.1+corex.3.2.0

xentropy_cuda_lib==0.1+corex.3.2.0上述软件由算力厂商持续更新中。

在 requements.txt 文件中指定上述软件版本将是无效操作。

-

应用中 天垓 100 使用 Docker

如果应用使用 Dockerfile 自定义环境,在 天垓 100 需要使用基础镜像,方可正常使用算力:

FROM registry.gitee-ai.local/base/iluvatar-corex:3.2.0-bi100

一个国产算力使用 Dockerfile 执行 Python 代码完整示例:

FROM registry.gitee-ai.local/base/iluvatar-corex:3.2.0-bi100

RUN useradd -m -u 1000 user

WORKDIR /home/user/app

RUN apt-get update && apt-get install -y git git-lfs && git lfs install

COPY requirements.tx[t] /home/user/app

RUN if [ -f ./requirements.txt ]; then \

pip install --no-cache-dir -r ./requirements.txt -i https://mirrors.cloud.tencent.com/pypi/simple; \

else \

echo "requirements.txt not found!"; \

fi

COPY --chown=1000 . /home/user/app

RUN chmod -R 777 /home/user/app

ENV PYTHONUNBUFFERED=1

EXPOSE 7860

ENTRYPOINT ["python3", "app.py"]

除了上述通用基础镜像,还有其他特殊镜像可供使用:

-

兼容 stable-diffusion-3-medium-diffusers 的基础镜像:

registry.gitee-ai.local/base/iluvatar-corex:3.2.0-sd3-bi100 -

量化类模型专用镜像:

registry.gitee-ai.local/base/iluvatar-corex:3.2.0-quant-bi100

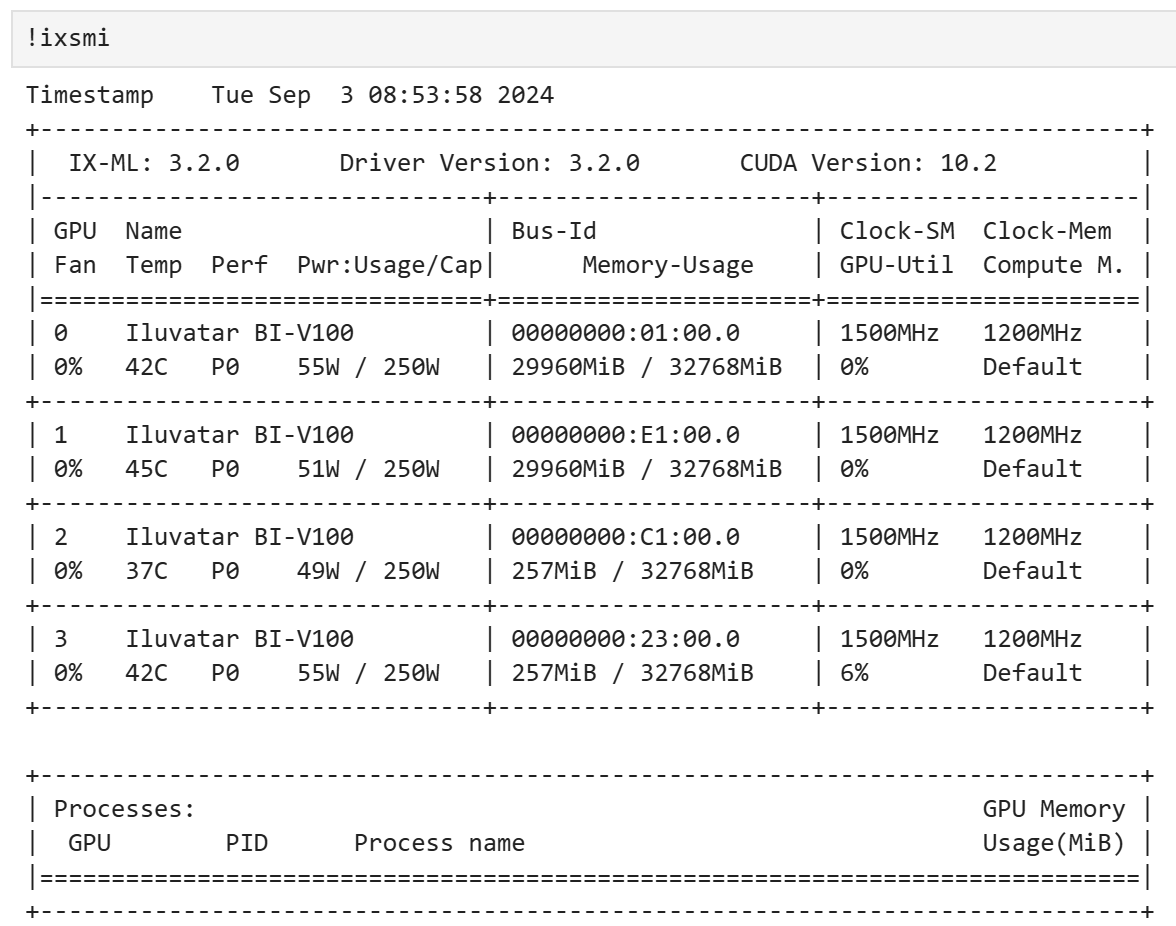

天数显卡查看显存

执行 ixsmi 命令可以查看显存使用情况,等同于 Nvidia nvidia-smi

对话模型加速

对话模型建议使用 vllm 获得最佳性能