应用 GPU 升级

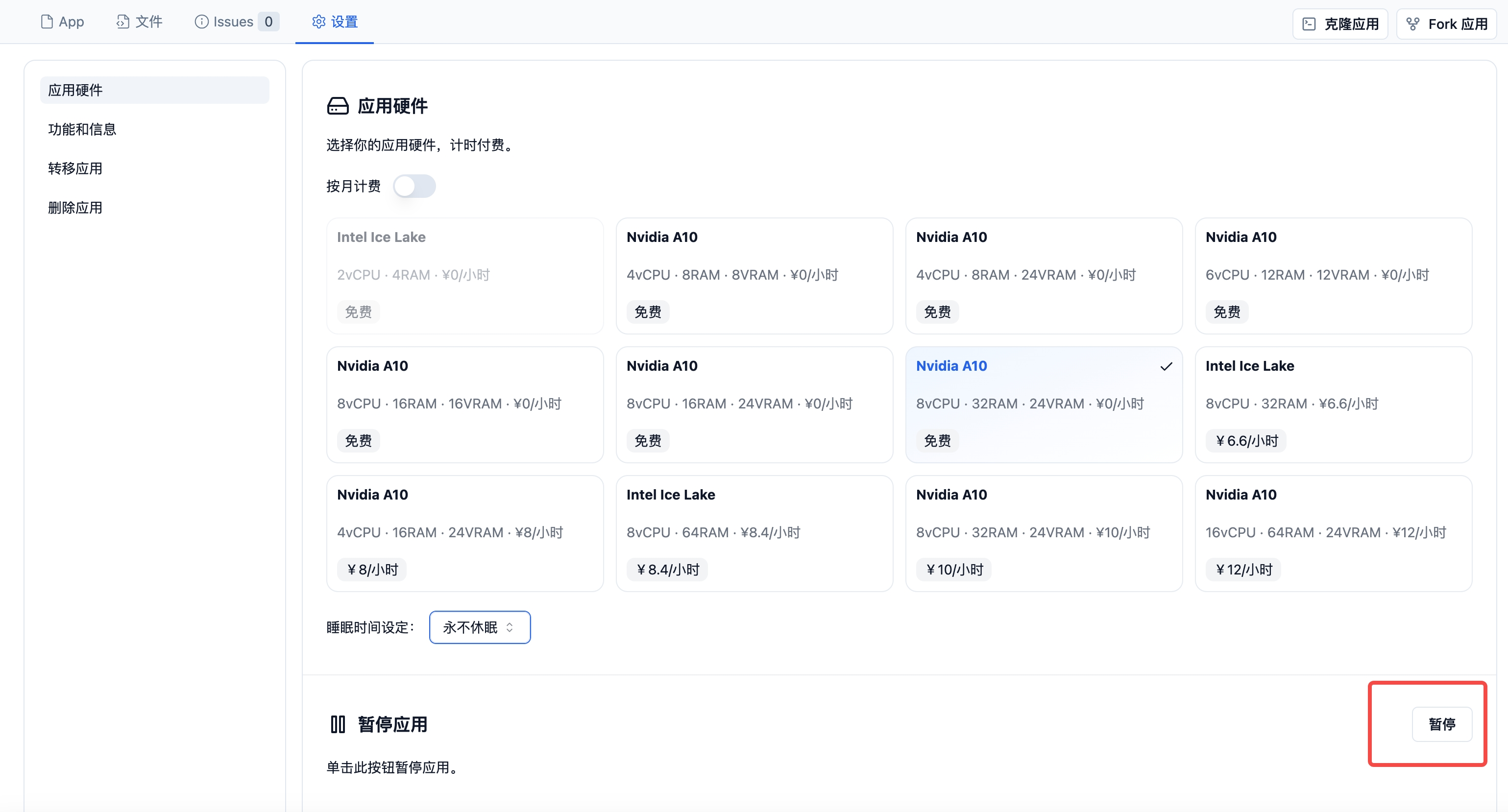

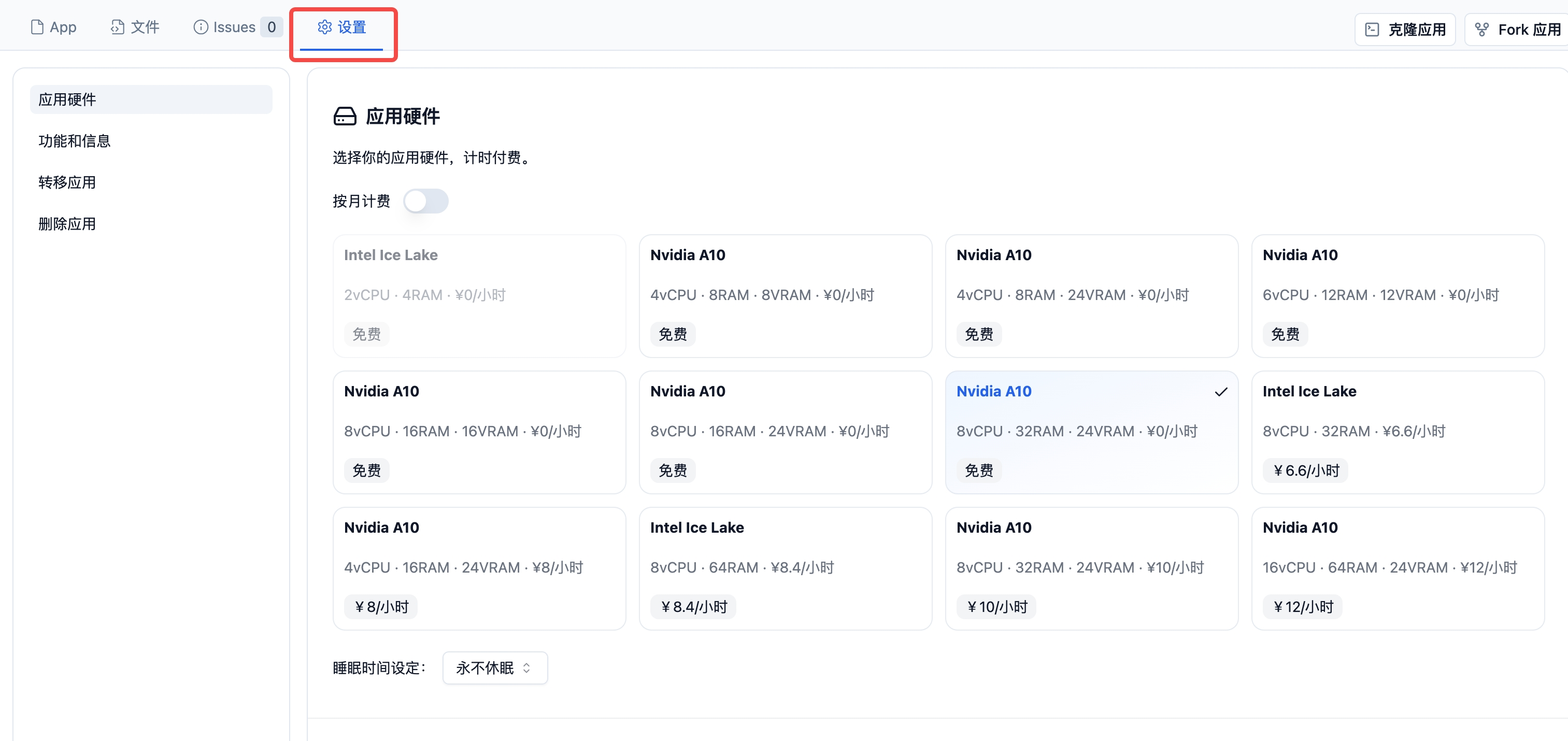

您可以使用应用顶部导航栏中的设置按钮升级��应用的GPU。

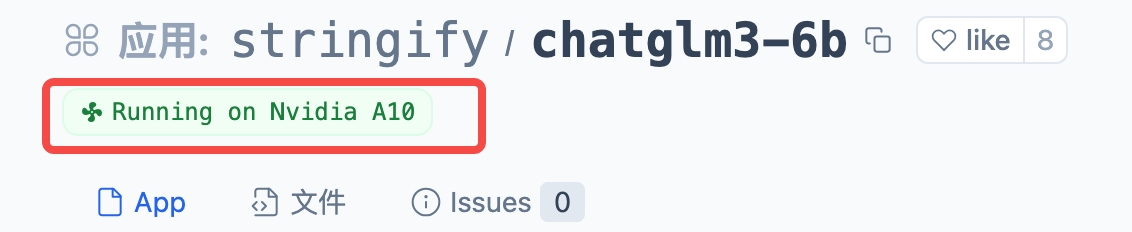

当您的应用运行时,您可以直接从小风车上查看它运行在哪个硬件上:

特定的框架要求

国产显卡已内置 torch、tensorflow、 vllm 等定制软件,请勿更换版本,否则算力可能无法正常还使用。

详情参考: 国产算力

PyTorch

Nvidia 显卡您需要安装与内置 CUDA 驱动程序兼容的 PyTorch 版本。将以下两行添加到您的 requirements.txt 文件中:

--extra-index-url https://mirrors.aliyun.com/pytorch-wheels/cu121

torch

您就可以通过在 app.py 中运行以下代码,从而检查空间日志中的输出来验证安装是否成功:

import torch

print(f"CUDA 可用: {torch.cuda.is_available()}")

# True

print(f"设备名称: {torch.cuda.get_device_name(torch.cuda.current_device())}")

# Tesla T4

大部分框架在检测到 GPU 可用的情况下会自动切换至 GPU 进行运算。这一点在 transformers、fastai 等众多框架的 Pipelines 相关功能中都能看到。然而,在某些情况下,当您直接使用 PyTorch 时,您可能需要手动将模型和数据转移到 GPU 上,以确保计算过程是在 GPU 而非 CPU 上执行的。这时,您需要利用 PyTorch 的 “.to()” 语法来实现,比如:

model = load_pytorch_model()

model = model.to("cuda")

类似的:

data = data.to("cuda")

Tensorflow

TensorFlow 默认安装后能够自动识别 CUDA 设备。您只需在 requirements.txt 文件中加入 tensorflow,并在您的 app.py 文件中使用以下代码,随后就可以在应用日志中检查确认了。

import tensorflow as tf

print(tf.config.list_physical_devices('GPU'))

# [PhysicalDevice(name='/physical_device:GPU:0', device_type='GPU')]

这段代码将帮助您验证 TensorFlow 是否已经正确设置,并且能够利用 GPU 设备进行计算。

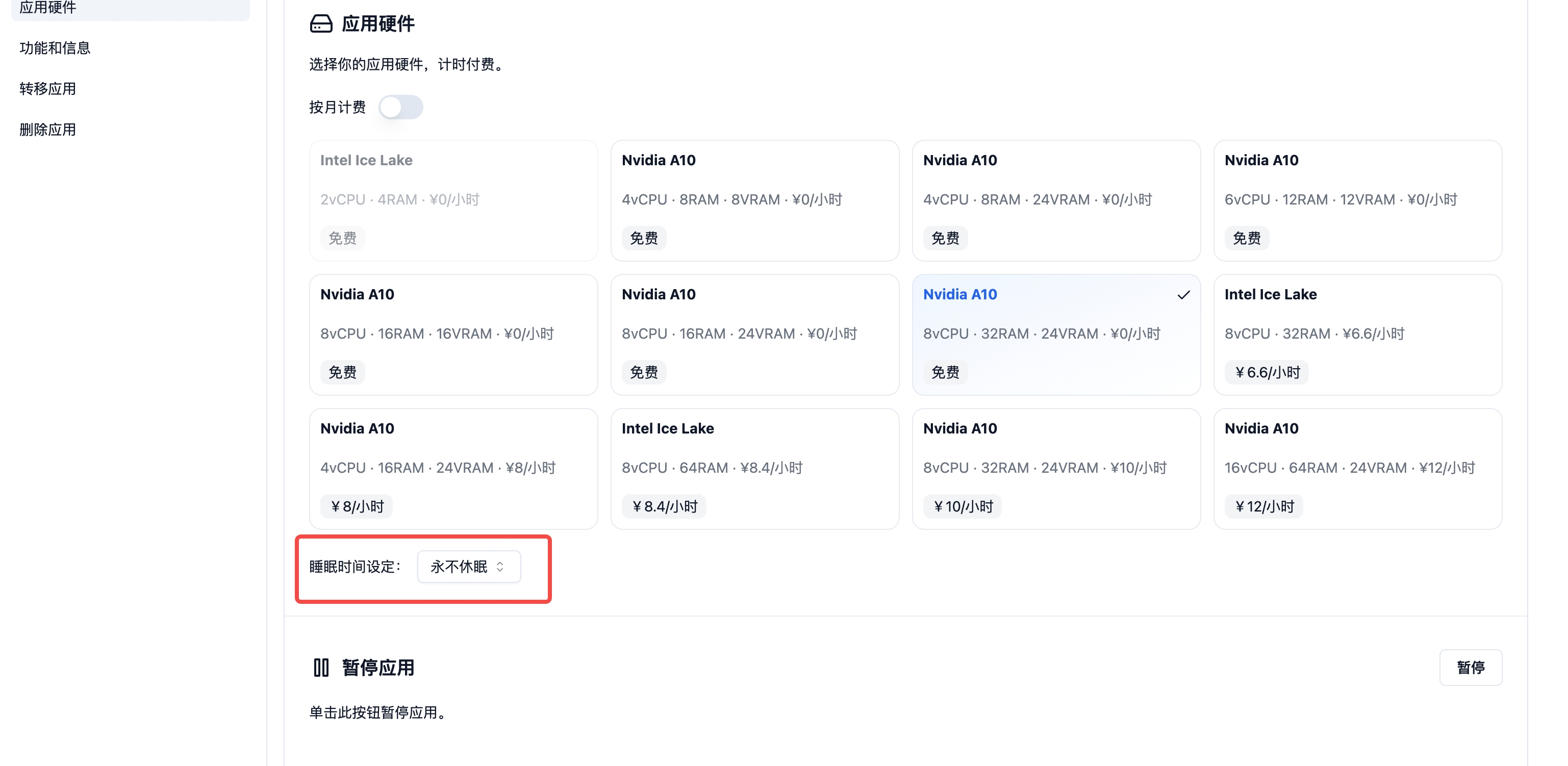

应用休眠

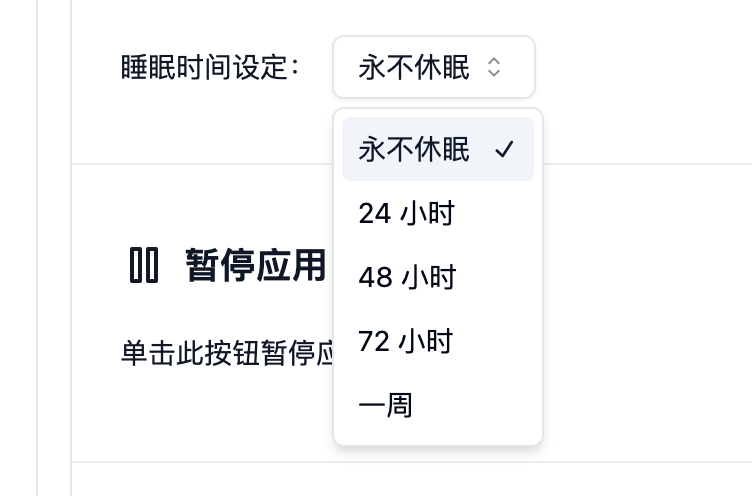

通常情况下,您的应用是不会自动休眠的。但是,您可以为您应用设置一个休眠时间,到期后应用自动停止运行。您也可以在设置中点击“暂停”按钮休眠, 在休眠状态下,应用硬件不会收取您的费用。

您可以在应用的硬件设置中看到以下界面配置选项:

具体选项如下:

应用暂停

您可以在设置中暂停您的应用。应用被“暂停”意味着该应用处于等待状态,应用不会使用任何资源,直到您手动重启为止,且只有应用的所有者能够重新启动它。暂停时应用不会产生费用。